太平洋科技 硬件

【AI时刻】GPT长眼睛了!史诗级功能悄咪咪发布!— OpenAI发布GPT-4V多模态模型

月亮背面的外星人

编辑: 孙奥睿

发布于:2023-10-02 00:23

PConline原创

月亮背面的外星人

编辑: 孙奥睿

发布于:2023-10-02 00:23

PConline原创

|

3月,在GPT-4的发布之初,OpenAI就表示将在本次的迭代中加入多模态整合,即不仅仅只通过文字输入进行识别分析,还可以通过语音输入、图片输入甚至视频输入进行信息的获取、识别、分析、输出。这项功能让不少用户深深期待,毕竟文字是抽象的,是需要一定的整合能力的,而图片一拍即合,简单自然,不用费劲儿地去描绘眼前的事物。

AI生成 我也曾写过一篇文章来描述GPT4的视觉识别系统,但当时其仅在一款叫做“Be My Eyes”的应用上应用,来帮助视觉障碍朋友进行一些基础的物品识别。

【Ai时刻】是谁独享GPT-4的视觉识别系统?让Ai成为视觉障碍者的眼睛 在经历法规限制、算力紧张、AI伦理大讨论以及各新进竞争者围追堵截后,北京时间9月26日凌晨,OpenAI悄咪咪发布了其GPT-4V模型,即多模态模型,其中最引人注目的还是视频识别功能,接下来就让我们看看其工作时是什么样的吧。 原视频地址点击图片查看 视频中的用户使用官方的ChatGPT iOS客户端进行演示。首先拍摄上传了一张自行车的照片,并询问GPT,如何帮助他将车座放下来。

GPT回答让用户找到快速释放杆或螺栓,打开它们,向下滑动座椅到合适高度,然后拧紧固定。并给出了经典的AI分点回答。

用户拍照确认了GPT所述的车座释放螺栓位置,GPT给出了肯定。

但最让我感到意外的是,其在结尾处,GPT在结尾处询问用户是否有工具,并拍照展示给它,它可以告诉用户用哪个!

用户将工具和清单拍给GPT后,GPT给出了肯定,并引导用户使用“工具箱的左边”的标记为DEWALT的4mm六角板子来松开阀座环上的螺栓并调整阀座高度。之后记得把它拧紧。

如果前面的自行车识别和车座调节识别都还是开胃菜,这一手“使用”工具真的把我嗅到了,展现出了GPT非常强大的物品识别、认知、分析能力。

今晨OpenAI还发表了一篇文章来解释、总结这一能力:OpenAI已经发布了一份详细的19页报告,关于其最新的多模态模型GPT-4V(ision),这一模型结合了其前身ChatGPT-4的语音和图像更新。该报告提供了大量关于模型开发和能力的信息。 GPT-4V是OpenAI于2022年完成训练,并计划在2023年3月开始提供早期访问的新型AI模型。GPT-4V的训练采用了与GPT-4类似的方式,先利用大规模标注数据进行无监督预训练,再通过强化学习的人机交互进行针对性调优。

AI生成 这种训练方式源自OpenAI与视障支援组织“Be My Eyes”的合作项目。OpenAI将名为“Be My AI”的视觉描述功能集成到“Be My Eyes”的手机App中,让盲人用户拍照后获得图像内容的语音描述。这种人机协作生成的多模态训练数据,极大地丰富了GPT-4V对真实场景的理解能力。

GPT-4V的图像理解能力突出,在地标识别、文字识别、人脸检测等任务上展现出较强的水平。具体来说,GPT-4V具备以下主要特征: -物体检测 - 可以定位图像中的各类日常物体,如汽车、动物、家具等,并可以判断数量和方位 -文本识别 - 具备字符识别能力,可以检测图中的字体和手写文字,并转录成文本 -人脸识别 - 可判断脸部的位置、性别、年龄、种族等面部特征 -验证码识别 - 通过视觉推理可以破解包含文字和图片的验证码 -地理定位 - 可以分析风景图像中出现的地标建筑,判断拍摄地的具体城市或地点。

AI生成 尽管能力强大,GPT-4V在处理复杂图像时仍存在局限。它在理解图像中的空间关系、处理重叠物体、分离前景背景等方面可能不太准确,也难以捕捉细微的文本和详情。 此外,GPT-4V的决策过程不透明,结果的可解释性有限。考虑到其破解验证码的能力,OpenAI也在评估其对互联网安全的潜在影响。综上所述,GPT-4V代表了多模态AI的重要进展,同时还面临诸多挑战。OpenAI表示会积极与研究团体合作,推动GPT-4V向着更可控、可解释和负责任的方向发展。 据悉该功能将于2周以内逐渐面向用户开放,但前提是能正常使用ChatGPT App。

|

原创栏目

硬件热点

硬件视频

IT百科

网友评论

聚超值•精选

-

- 公牛CR2032纽扣电池cr2025cr2016汽车钥匙遥控器通用3V圆形锂电池适用宝马奥迪日产丰田丰田大众吉利哈弗长安

- 券后省2

-

¥3.8

¥5.8

- Apple/苹果2022款MacBookAir13.6英寸M2(8+8核)8G 512G 深空灰轻薄笔记本电脑 Z15S00078【定制】

- 券后省1500

-

¥8999.0

¥10499.0

- Apple苹果 iPad mini 6 第六代 8.3英寸平板电脑 2021款(256GB WLAN版/A15芯片/全面屏/触控ID)紫色

- 券后省100

-

¥4599.0

¥4699.0

- 铭凡(MINISFORUM)HX99G 锐龙独显RX6600M/6650迷你主机小电脑8G显存高性能游戏设计台式机 HX99G(R9 6900HX+RX6600M) 双通道32G DDR5/1TB S

- 券后省400

-

¥5299.0

¥5699.0

- vivo Y100 8GB+128GB 璃光蓝 超薄5000mAh电池 6400万OIS光学防抖 44W超快闪充 5G 快充 拍照 手机

- 券后省10

-

¥1389.0

¥1399.0

-

- 中国电信星卡流量卡山东河南湖南广北京吉林宁夏电信星卡29元长期套餐无合约全国通用 宁夏星卡: 39元260G+100分钟+长期套餐

- 满5减1

-

¥1.08

¥5.1

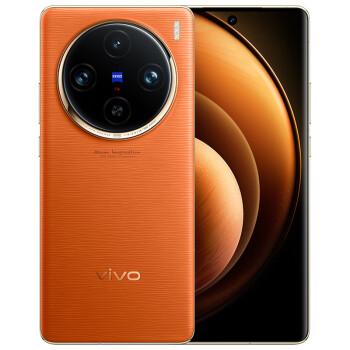

- vivo X100 Pro 12GB+256GB 星迹蓝 蔡司APO超级长焦 蓝晶×天玑9300 5400mAh蓝海电池 自研芯片V3 手机

- 券后省10

-

¥4989.0

¥4999.0

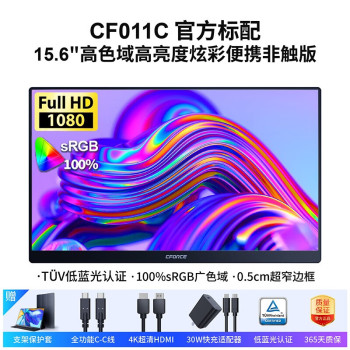

- CFORCE 15.6英寸便携显示器窄边框高色域0坏点原装屏手机电脑显示屏笔记本一线直连switch副屏PS5扩展屏 【IPS 100%色域】轻办公推荐 11C

- 券后省230

-

¥619.0

¥849.0

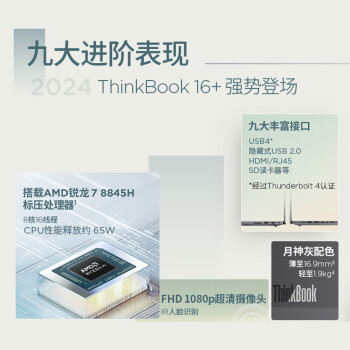

- ThinkPad联想笔记本电脑ThinkBook 16+ 2024 锐龙版 AI全能本 R7-8845H 16英寸 32G 1T 2.5K 高刷屏办公

- 券后省10

-

¥5689.0

¥5699.0

- vivo X100 Pro 16GB+512GB 落日橙 蔡司APO超级长焦 蓝晶×天玑9300 5400mAh蓝海电池 自研芯片V3 手机

- 送赠品

-

¥5449.0

¥5499.0

-

- 轻磁 MFi认证真液态硅胶快充数据线适用于苹果L口快充 安卓华为小米TypeC 60W 3A充电线 【梧枝绿】C转L【MFi认证】1米 PD60W快充线

- 券后省10

-

¥68.0

¥78.0

- 西部数据(WD)NVMe 移动固态硬盘(PSSD)My Passport随行SSD type-c接口 1050MB/s 手机笔记本外置外接 高速 宇宙蓝(传输速度1050MB/s) 1TB

- 送赠品

-

¥739.0

¥759.0

- Apple/苹果 Watch SE 2023款智能手表GPS款44毫米银色铝金属表壳风暴蓝色运动型表带M/L MREE3CH/A

- 券后省350

-

¥1849.0

¥2199.0

- 唯卓仕24mm F1.8索尼口全画幅自动对焦镜头适用于FE卡口A7M4/R4/M3 A7C2微单相机广角定焦大光圈人像镜头 AF 24/1.8 FE 官方标配

- 券后省30

-

¥1959.0

¥1989.0

- Aqara 绿米智能墙壁开关D1 zigbee零火单火米家App苹果HomeKit小爱同学 【白】D1单火三键(无零线也能用

- 券后省20

-

¥189.0

¥209.0

-

- 【2023游戏旗舰本】HP/惠普光影精灵9/暗影精灵英特尔酷睿i7 RTX4060学生办公游戏笔记本电脑惠普官方旗舰店

- 券后省500

-

¥6195.0

¥7895.0

- 微软原装国行Xbox Series X/S无线蓝牙OneS手柄控制器星空SteamPC游戏单机大作Elite精英版二代Remix 特别版

- 券后省1

-

¥167.0

¥210.0

- 西部数据(WD) 4TB 移动硬盘 type-c Mac专用 My Passport Ultra2.5英寸 银 机械硬盘 手机笔记本外置外接

- 券后省20

-

¥969.0

¥989.0

- 毕亚兹 企业级HDMI无线投屏器 高清办公会议同屏器 点对点转换器 适用笔记本电脑主机连接电视投影仪 R56

- 券后省10

-

¥1989.0

¥1999.0

- 阿思翠(Astrotec)GX70有线HIFI游戏音乐耳机入耳式高音质可换线 黑色

- 券后省15

-

¥184.0

¥199.0

月亮背面的外星人

月亮背面的外星人

硬件编年史

硬件编年史