太平洋科技 硬件

【AI时刻】“我免费了!”谷歌推出开源AI语言模型Gemma

月亮背面的外星人

编辑: 孙奥睿

发布于:2024-02-22 12:22

PConline原创

月亮背面的外星人

编辑: 孙奥睿

发布于:2024-02-22 12:22

PConline原创

|

最近的AI圈有点太热闹了,各大科技巨头纷纷展示其技术实力。Google前脚推出了Gemini 1.5版本,炫耀其强大的技术能力。后脚,OpenAI以其Sora就实现了压倒性的胜利,似乎为“GO”(Google和OpenAI)之间的这场AI竞赛画上了句号。然而,就在昨晚,Google悄然发布了一项新技术,犹如一枚小型炸弹,旨在重新平衡这场竞技的比分,使比赛再次充满悬念。

它就是基于Gemini技术并实现了开源的Gemma,这是一款轻量级、先进的开源模型,供开发者和研究人员用于AI构建。Gemma模型系列包括了两个版本,分别是Gemma 2B和Gemma 7B,这些模型在技术架构和基础设施方面与Gemini保持一致,确保了在各自的规模类别中,二者都能实现对同级对手的超越。

Gemma模型的设计理念使其不仅能够在开发者的个人笔记本电脑或桌面电脑上运行,而且在关键的基准测试中其表现皆优于其他体量更大的模型。

截止到发稿日,Gemma已经开启使用体验

Gemma的主要特点 轻量级、高性能模型 Gemma模型以轻量级和高性能脱颖而出,其中包括Gemma 2B和Gemma 7B两种规模,均提供预训练版本和可通过指令优化的变体。在相应尺寸范围内的模型比较中,Gemma模型展现了不错的能力,尤其在处理复杂的任务时,其效率和精确度中更是部分成绩超过了Meta开发的LLama(其是目前最流行使用的开源LLM)。

在谷歌官方给出的测试成绩中,Gemma 7B的模型成绩已经完全超过LLama-2 13B模型的成绩 跨框架工具链支持 Gemma模型的设计理念是兼容性和灵活性,从而支持业界主流的框架,包括JAX、PyTorch和TensorFlow。通过原生Keras 3.0的支持,不仅能够进行高效的推理操作,也支持监督式微调(SFT),满足了不同开发者的需求和在多样化的开发环境中的使用。 易于入门和集成 开发者可以利用Gemma模型提供的Colab和Kaggle快速启动和运行项目。此外,Gemma模型与Hugging Face、MaxText、NVIDIA NeMo和TensorRT-LLM等行业内的流行工具集成无缝,使得开发者无需在集成工具上花费大量时间,即可专注于模型的高效应用。 高效的运算能力 为了达到行业领先的性能标准,Gemma模型针对多个AI硬件平台进行了优化,特别在NVIDIA GPU和Google Cloud TPU上展现了出色性能。与NVIDIA的紧密合作进一步确保了不论是在数据中心、云端还是本地搭载RTX显卡的个人电脑上,Gemma模型都能提供一流的性能和技术整合。

可能带来的影响 之前我们也在AI时刻的文章中说过,想要在移动侧跑AI模型,模型的参数量就是一个最大的限制,越大的参数量会消耗越多的性能与内存,对移动端的综合体验是不利的,而Gemma的出现,让小参数量模型也可以实现不错的性能表现。 尤其是Gemma模型的2B版本特别值得关注,它是在轻量级AI模型领域的一次重大突破。传统上,小参数量的模型通常意味着必须在性能上作出妥协,但Gemma 2B通过先进的优化算法和结构设计,成功在保持模型体积小巧的同时,实现了与更大模型相媲美的性能。 这对移动端AI的发展具有深远的意义。首先,它使得在资源受限的设备上运行复杂的AI应用成为可能,从而拓展了AI技术在移动和边缘计算领域的应用范围。这不仅提升了用户体验,而且为在移动设备上实现实时数据处理、增强现实(AR)、个性化推荐等高级功能打开了大门。

甚至未来,我们可以看到在智能手表、AI智能戒指等设备上看到小参数量模型的身影,让这些设备也具备轻度的AI处理能力,大大丰富其使用功能。 另外,由于Gemma实现了开源,其可以允许开发者对其进行商业化的应用,那么在今年的手机端AI应用中,我们预计,在今年,市场上将涌现出一系列由Gemma或与Llama模型协同开发的创新产品。这些产品的问世标志着手机端AI应用迈向了一个新的里程碑。 |

原创栏目

硬件热点

硬件视频

IT百科

网友评论

聚超值•精选

-

- 尼康(Nikon)Z6II(Z6 2/Z62)全画幅微单机身 微单机身(约2,450万有效像素 5轴防抖)

- 券后省50

-

¥11449.0

¥11499.0

- 铁威马(TERRA MASTER) F4-423(8G)企业级高配 NAS网络存储 四核2.5G网口 F4-423(8G版)标配-空机无硬盘

- 券后省400

-

¥1799.0

¥2199.0

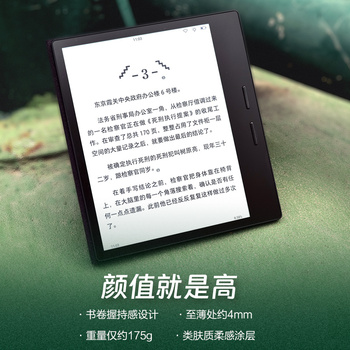

- 【咨询再减】掌阅iReader Ocean3智能电子书阅读器墨水屏电纸书阅览器7英寸小迷你护眼看读书水墨屏pdf阅读器

- 券后省30

-

¥1269.0

¥1663.0

- 华硕ROG XG27ACS绝杀 27英寸2K 144Hz电竞显示器原生180Hz高刷 FastIPS 1ms响应G-SYNC兼容HDR400认证

- 券后省100

-

¥1999.0

¥2099.0

- 漫步者(EDIFIER) W820NB双金标 Hi-Res主动降噪耳机 头戴蓝式牙耳机适用苹果安卓 【双金标版】典雅灰+耳机包

- 每满399减30

-

¥359.0

¥399.0

-

- 中国电信流量卡手机卡上网卡不限速5G翼永卡龙舟卡新星卡阳光卡仰望卡长期静卡嗨卡 翼枫卡29包210G流量200分钟 送40话费

- 券后省4

-

¥1.01

¥5.0

- 西部数据(WD)4TB 移动硬盘 P10 游戏高速存储大容量机械硬盘ps5/xbox拓展外接外置手机笔记本电脑

- 券后省10

-

¥889.0

¥899.0

- HKC显示器27英寸2K高清IPS家用办公笔记本外接台式电脑屏幕S2716Q

- 券后省106

-

¥589.0

¥705.0

- 拾光坞N3云盘星光版V/NAS私有云网盘/云存储/离线下载/docker/影视墙/低功耗 星光版- V 黑色

- 券后省102

-

¥377.0

¥479.0

- 华硕 追影13/14代i7 14700KF吃鸡永劫无间直播设计师电竞游戏台式电脑主机diy组装整机 规格三丨新i7 14700KF/RTX4060

- 券后省800

-

¥7599.0

¥8399.0

-

- 中国电信手机卡流量卡上网卡5G套餐通用100g星卡不限速畅享天翼支付学生校园卡高速 长期牛卡29包185G全国流量长期套餐 送30话费

- 券后省4

-

¥1.01

¥5.0

- Apple/苹果 Watch Series 9 智能手表GPS款41毫米午夜色铝金属表壳 午夜色运动型表带S/M MR8W3CH/A

- 券后省400

-

¥2549.0

¥2949.0

- 诺可信(Nokoxin)2.5G交换机10G光口支持猫棒千兆宽带 一键VLAN模式非管理型 4个2.5G电口+2个10G光口/支持猫棒

- 券后省30

-

¥219.0

¥249.0

- AOC Q2790PQ 27英寸显示器 2K高清 IPS广视角 广色域 节能低蓝光 75HZ 可升降旋转液晶电脑显示屏

- 券后省10

-

¥1139.0

¥1149.0

- 火影众颜U6/锐龙7/16英寸/2.5K/120Hz高性能轻薄商务笔记本电脑 众颜U6:R5-6600H/16G/512G/2K

- 券后省300

-

¥2899.0

¥3199.0

-

- 中国联通 手机卡流量卡上网卡校园卡学生全国通用不限速5G奶牛卡沃派宝卡王卡大萌卡 惠艺卡29元每月200G通用流量+100分钟通话

- 券后省4

-

¥1.01

¥5.0

- vivo Y100 8GB+128GB 璃光蓝 超薄5000mAh电池 6400万OIS光学防抖 44W超快闪充 5G 快充 拍照 手机

- 券后省10

-

¥1389.0

¥1399.0

- ThinkPad联想笔记本电脑ThinkBook 14+ 英特尔Evo 14英寸轻薄办公本 13代i5-13500H 32G 512G 2.8K 90Hz

- 券后省10

-

¥5489.0

¥5499.0

- 西部数据(WD) 2TB 移动硬盘 type-c My Passport Ultra 2.5英寸 金 机械硬盘 手机笔记本外置外接 兼容Mac

- 券后省10

-

¥629.0

¥639.0

- ikbc键盘机械键盘无线w210红茶青轴键盘鼠标套装游戏电竞有线樱桃键盘电脑办公人体工学键盘 C210时光灰有线108键红轴

- 券后省30

-

¥249.0

¥279.0

月亮背面的外星人

月亮背面的外星人

硬件编年史

硬件编年史