|

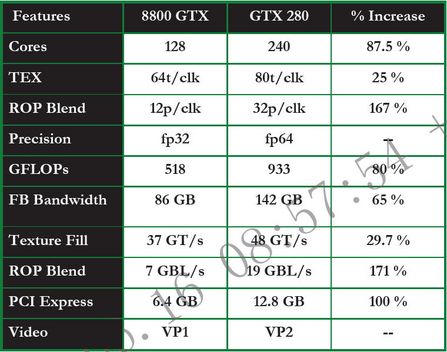

前言 nVidia又出击了,当大家还在为GeForce 9800GX2性能保持怀疑,与HD3870x2显卡性能争夺面红耳赤的时候,nVidia又提前给我们带来了新一代旗舰产品——GeForce GTX 280显卡。拥有目前顶级显卡1倍数量的流处理,NV史无前例的512bit显存位宽、14亿个晶体管数量,支持物理加速这些都是GeForce GTX 280还没上市之前就给大家留下的深刻印象。凭借这些,GeForce GTX 280显卡毫无疑问的成为了当今显卡的性能之王。 如今,GeForce GTX 280终于登上了舞台,Geforce GTX 280 显卡采用了 65nm技术,全新的第二代统一架构,显卡集成14亿晶体管电路,核心频率 602MHz,其240颗流处理器频率为1296MHz。GTX 280 显卡配备了1GB GDDR3显存,采用了512-bit位宽,有效显存频率2214MHz, 显存带宽高达141.7GB/s。 GTX 280拥有80个纹理单元和32个光栅化单元,提供48.2 G/秒纹理数据处理能力...... 除了强劲的3D性能之外,GeForce GTX 280同时给我们带来了在并行运算方面的革命,重新设计的第二代统一架构,240个完整的ALU,高达933GFOLPS浮点处理器能力,第二代Dual Issue、支持双精度这些都是专门为科学计算而优化的。加上目前日趋完善的CUDA环境,GeForce GTX 280的革新远不是简单的3D性能提升。 第1节 G80/G92第一代统一处理架构回顾 1.1 Geforce8800采用Unified Shader架构: DirectX 10最大的革新就是统一渲染架构(Unified Shader Architecture)。之前的GPU架构还是沿用的分离式渲染架构,在G80核心推出之前的G71和ATI的R580都是采用这样的架构,顶点渲染和像素渲染各自独立进行,而且一旦当架构确定下来,顶点和像素shader单元的比例就会固定下来。不过分离式渲染架构设计更为简便而且经验丰富,例如NVIDIA的NV40发成到后来的G70/G71,又或者是R420到R580,性能都得到显而易见的提升。 微软认为这种分离渲染架构不够灵活,不同的GPU,其像素渲染单元和顶点渲染单元的比例不一样,大大限制了开发人员自由发挥的空间。不同的应用程序和游戏对像素渲染和顶点渲染的需求不一样,导致GPU的运算资源得不到充分利用。微软在DirectX 10中提出了统一渲染架构,在通用和独立的shader单元中可以执行不同的shader程序,包括vertex、pixel和在DirectX 10中首次提出的geomery shader。而且随着这些通用独立的shader单元功能的不断完善,日后有望执行更多的shader程序,例如物理效果。 相对顶点渲染来说,像素渲染将面临大规模使用纹理所带来的材质延迟,这是统一渲染架构急待解决的问题。不过在Geforce880 GPU里面,这种情况得到很大的改善,分组的steam processor都用联立一定数量的texture单元和L1/L2高速缓存。 Shader Modle 4.0无论是vertex还是pixel指令,最大指令长度相当于Shader Modle 3.0的128倍(64K),越长越复杂的指令可以产生越真实的画面,Shader Modle 4.0的寄存器也激增到4096个,Constant寄存器采用16×4096阵列。input寄存器采用16/32规格等,上述指标都比以前的DirectX有明显的改进。Shader Modle 4.0允许程序员在渲染物体时使用128个纹理,而DirectX 9只提供4/16规格,更多的纹理意味着物体表面精度更真实,游戏开发者拥有更广泛的选择。 1.2 传统Pipeline模型 VS Unified Shader模型 Geforce8800 GPU的研发工作从2002年夏天正式开始。Geforce8800 GPU的设计当时有四大目标。显而易见的超过当代的GPUs、提升图像质量、提供强大的物理和浮点处理性能,适应DirectX的发展推出新概念的GPU Pipeline。

传统经典的Pipeline模型,不同种类属性的vertices,包括index、commands和textures,线性缓冲区的Setup引擎自上而下的经过vertex shading、 pixel shading和ROP,最后被写进frame buffer。事实上Geforce7系列GPU拥有超过200个连续的阶段。 显而易见的,采用了Unified pipeline设计的Geforce8800 GPU可以有效的减少pipeline的层数,同时将传统经典pipeline自上而下的线性顺序变成连续的循环导向的过程。input经过unified shader core作为output写进去寄存器,同时返回到shader core再进行下次操作。 在不同应用程序和游戏中,vertex shader和pixel shader的需求比例不尽相同, 十分不幸地在Geforce8800 GPU之前,GPU里面的vertex shader和pixel shader的比例是固定。显然unified的实际适应性更强,从下面的例子我们可以看到在unified shader架构的威力,大大提升了GPU的硬件使用率,尽量避免shader空闲的情况发生。 1.3 为什么需要Unified shader架构? 在典型的HDR代表游戏《上古卷轴4:湮灭》中,7900GTX在2048x1536并开启HDR的情况下,FPS惨不忍睹。独立渲染的草丛或者树叶是由庞大数量的多边形构成,对GPU的vertex shader和geomery shader提出严酷要求,相对来说并不需要太多像素操作,如此一来大规模的像素渲染被闲置而顶点模块处于不堪重负状态。Unified shader架构则可以帮我们解决硬件资源上的限制,Unified shader架构也尽量降低了shader单元的闲置率。 1.4 G80里面的核心部件-Streaming Processors 在Geforce8800 GPU的unified shader架构里面,Streaming Processors(SPs) 是最为核心的单位,Geforce8800GTX拥有128个streaming processor,运行在1350Mhz的频率下。每个streaming processor均能处理vertex、pixel、geometry等操作,是一个通用的浮点处理器。 这些浮点处理器都可以随时有计划的编排分组成不同的工作量。

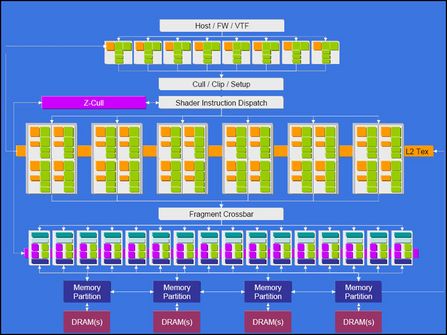

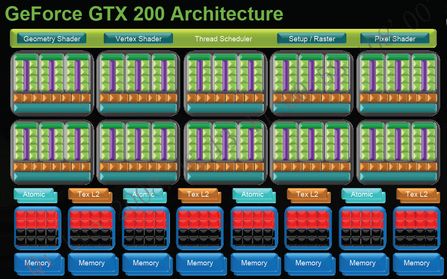

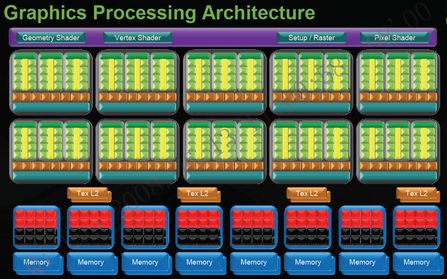

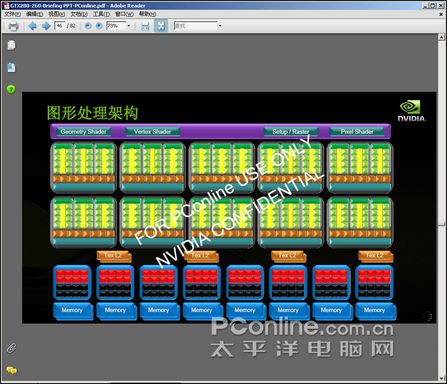

Steam Processing架构的运作 对geometry shader有了一定认识以后,我们现在具体看看Steam Processing架构的运作。 Geoforc8800 GPU通过一定数量的SP去完成shader操作,相邻的SP可以十分方便的分组发挥并行操作的威力,在Geforce8800 GPU架构中,每16个SP分为一组。 不同属性基础的数据流在整合了专门高速指令解和执行逻辑的SP和一些类似的操作中执行,内建的Cache快速的存储SP的输出,而这些Cache又可以作为input被其他的SP读取。SIMD操作非常高效地在已被分组的SP集合里面执行。 下图可以看到streaming processors和联立的texture Flitering(TF)和texture addressing(TA)。显然内建的L1/L2 Cache确保了平衡的设计,这是一个典型的Geforce8800 GPU unified shader设计。128个streaming processors并行构成了8800GTX的shader架构。每个SP都是通用的、不相关的和标量地,可以同时进行MAD和MUL操作,支持IEEE 754精度的浮点。 1.5 Geometry shader(几何着色器) geomery shading是DirectX10的新特性,streaming processors可以处理几何运算,大大减轻了CPU在几何运算的负载。GPU分派器和控制逻辑可以动态的指派streaming processpors进行vertex、pixel、geometry等操作,因为他们是通用的。显然unified shader设计可以建立更加平衡的shader工作机制,但是传统的pipeline定义不再适用,在未来,可能其他特性的预算也可以通过unified streaming processor去完成。我们看看geomery shader的情况。 Input Assembler(IA)从顶点缓冲区上的输入流中接收顶点数据,并且把数据项转换为规范的格式。vertex shader通常用来把顶点从模型空间变换到平面空间,vertex shader读取一个顶点,输出一个顶点。Pixel Shader读取单一pixel属性,输出包含颜色和Z信息的的片断。而geometry shader是DirectX10提出的,把同一区域的所有顶点作为输入,产生新的顶点或者区域。此外数据流输出(steam output)把geometry shader输出的顶点信息复制为4个连续的输出缓冲子集。理论上来说,steam output的输出能力Input Assembler的输入能力相匹配。 Shader就是一段可以改变像素、顶点和几何学特征的小程序。Vertex Shader是专门处理多边形顶点的。那么Geometry shader就是专门用来处理场景中的几何图形。在过去Vertex Shader每一次运行只能处理一个顶点的数据,并且每次只能输出一个顶点的结果。在整个游戏场景中,绘制的几何图形的任务量非常庞大,如果仅仅依靠Vertex Shader单一来完成,效率会极其低下。 现在DX10的设计师们在顶点与像素的处理过程中又加入了(Geometry shader)几何着色器。它可以根据顶点的信息来批量处理几何图形,对Vertex附近的数据进行函数处理,快速创造出新的多边形。通过steam out将这些结果传递给其他Shader或buffer,将CPU从复杂庞大的几何运算中解放出来。大爆炸,粒子效果,瀑布流水等复杂又关联的场景都可以用Geometry shader很逼真的表现出来。 1.6 Texture和math-相互没有关联的多线程操作 Texture寻址、过滤和fetching都会耗尽相当多GPU的核心时钟。如果在架构需要在一个数学操作之前进行Texture的操作,例如是16x各向异性过滤,系统的延时将会大大增加。Geforce8800 GPU作出重大的改进,在进行相当的独立算术运算的时候,“隐藏”了Texture fetch的延迟。 在Geforce7系列的GPU中,Texture寻址计算是采用隔行扫描进行的,这种设计在遇到texture fetch的时候就会遇到瓶颈。Geforce8800 GPU可以完全独立的进行texture操作和shader算术运算。 在Geforce8800架构开发的初期,NVIDIA工程师分析了数百种包含越来越多的标量计算的shader程序以后发现,一些混合了矢量和标量的指令,特别是一些比较长的shader很难有效的在矢量的架构中处理操作。标量计算在矢量的流水线中编译非常困难。 NVIDIA和ATI的都可以处理两个指令,在R580中,ATI采用的3+1架构可以处理一个2x2的矢量指令和由1x3矢量指令和1x1标量指令的混合,在Geforce6/7中,可以操作2+2和3+1的双指令操作。但是这些跟Geforce8800 GPU的标量设计那么高效。NVIDIA的工程师作出评估,128个标量处理器的标量架构拥有两倍性能于32个复合的矢量处理器架构。 1.7 Early-Z技术 当代的GPU都会采用Z-buffer去记录哪些像素是可见,而哪些像素是被遮挡而不可见。一个3D Frame最终要转换成为2D图像才能表示在屏幕上面,来自GPU连续的顶点流(vertices)会构建这个frame,从这个顶点流获取相应的2D坐标去生成多边形。多边形的连续产生会覆盖原来的区域,因而Z-buffer的信息就是告诉ROP, 哪些像素是可见哪些是不可见的。提前进行的Early-Z对比可以节省大量资源,因为同一个区域被多个多边形覆盖的次数轻而易举地达到原来的四倍甚至更高。 目前甚少方法可以利用Z-buffer信息去挑选或者排出被遮挡像素的渲染,Z-Cull就是这样的一个方法。Z-comparision通常会发生在ROP的后期。问题就产生,意味着pixel要通过完整的ROP管线才能被发现是否可见。一些复杂的包含数千步骤的shader程序,即使是被遮挡的pixel也全部通过流水线,这显然浪费了GPU的性能。Early-Z移去不可见像素在它们进入流水线之前,这样显然会提高性能,NVIDIA认为这个操作提升22%附近的性能。 1.8 G80的填充率计算: 数据很方便的在不同的SP之间的output和input之间移动,例如vertex data处理完以后,output可以作为input发送到Geometry Theard。 每个在8800GTX运行的SP都运行在1.35Ghz,并能同时执行一个MAD和MUL的标量操作,因而8800GTX就用有520 gigaflops的shader处理能力,不过这并不是8800GTX的全部实力,因为指令发送100%适用于矢量操作, 而标量和矢量混合的shader程序编码比特定的组合指令发送更有效率(3+1或者2+2) texture过滤单元和SP互不相关的传送64 pixel每个时钟,这等于每个时钟完成32 pixel的寻址或者是32 pixels 2x各向异性过滤,或者是每时钟32pixels的双线过滤。 基本上,FB16双向材质过滤可以实现每时钟32pixel来操作,如果是FP2:1的各向异性过滤也可以每时钟16pixels来完成。texture单元运行在575Mhz的时钟频率,这也就是8800GTX的核心时钟频率。 在575Mhz的运行频率上面,双线过滤或者是2:1的各向异性过滤的填充率达到575Mhzx32=18.4billion texels/s的水准,2:1的各向异性过滤相当于两个双向过滤取样一起整体输出到一个像素,因而8800GTX拥有36.8billion texels/s的双向过滤的填充率。 1.9 G80的ROP(Raster Operation partitions) 8800GTX拥有6组ROP(Raster Operation partitions),每组可以处理4个像素,因而一共可以每时钟可以处理24个包含颜色和Z信息的像素。如果是Z-only处理,则可以实现每时钟192个单像素的处理。如果是4x 多取样反锯齿MSAA(multisampled antialiasing)打开,则可以完成48个Z-only操作。 G80的ROP支持超级采样和多点采样和适用(Adaptive)的这三种抗锯齿(antialiasing)的模式, 因而G80是首个在单GPU环境下实现8x、 8xQ、16x和16xQ等antialiasing模式的GPU。NVIDIA引入了CSAA,Coverage Sampling Antialisaing-新的全屏抗锯齿选项,同时包含coverage取样和geometry取样。CSAA有新的选项分别是8x、8xQ、16x和16xQ, 全面提升了全屏抗锯齿的等级。得益于G80强大的性能,在某些游戏开启16x高质量的AA模式以后,速度并不会大幅降低,系统花销可以维持在4x AA的级别。 G80的ROPs支持FP16和FP32的混合,无论是FP16还是FP32都能够进行多采样抗锯齿(multisampled antialiasing),因而从G80开始,NVIDIA的GPU首次实现HDR+AA的模式。8个支持DirectX10的多渲染目标MRTs(Multiple Render Targets)引用在G80,可以进行色彩和Z操作。DirectX10支持两种新格式的HDR、第一种格式是R11G11B10,特别的为存储texture的浮点格式优化,另外一种这是每个颜色通道占用9bit,RGB各占9bit,专门为渲染目标(render target)而设计。 每组ROP拥有64bit的显存接口界面,完全支持DDR1、DDR2、DDR3、GDDR3和GDDR4显存,因而8800GTX一共拥有384bit的显存接口界面,也就是我们所说的384bit的显存位宽,8800GTX一共拥有784M的本地显存,运行在900Mhz时钟频率的GDDR3显存一共提供86.4GB/S的恐怖显存带宽。 第2节 GT200第二代统一架构特点: 提高性能同时提升了效率 GeForce GTX 280显卡的出现终于给我们带来了全新的第二代统一架构。而第二代统一架构最大的特点就是在全部继承第一代统一架构的优点后,提升各单元处理器能力的同时也提升了效率,真正意义上把同一架构发挥至极点。为了适应未来并行运算的需要,GeForce GTX 280显卡开创性的提供了2种不同的架构——并行处理架构与图形处理器架构。 从上面的架构图可以看出,GeForce GTX 200系列可以分为四个层,最上面一层包括了图形处理器所需要的几何着色器(Geometry Shader)、顶点着色器(Vertex shader)以及像素着色器(Pixel shader)。中间一层包括了10组TPCs(计算处理器群集),每组TPC里面又包含了3组SMs(流处理器组),每组SM里面就包含了8个流处理器单元或计算单元。这样一来,GeForce GTX 200显卡就一共包含了240个流处理器单元或计算单元。在TPCs下面就是纹理单元以Atomic单元(在并行计算中负责处理冲突的单元)。在下面就是ROPs(光栅化处理器引擎)以及显存接口。

从上面的规格对比表中可以看出,GeForce GTX 280比起GeForce 9800GTX,主要的改进有以下几点: 1、大幅度增加了晶体管数量,浮点处理器能力接近1000GFlops。 2、Stream processor数量也由上代的128个增加到240个,性能增加的同时跟纹理单元保持更好的平衡,能更好的适用目前及未来的游戏。 3、显存位宽也有成本的增加,终于突破了512bit,在搭配GDDR3的情况下,显存带宽达到了惊人的142GB/S、 4、GeForce GTX 280的ROPs单元跟纹理单元也增加值32个和80个。 上面多点都是GT200核心的GeForce GTX 280系列所具备的特点,同时,作为目前新的旗舰产品,GeForce GTX 280仍然支持nVIDIA的3-Way SLi以及第二代PureVideo HD高清引擎。 第3节 图形处理器:性能成倍提升 3.1 优化的shader/TF比值 适应未来的需求 在图形处理方面,GeForce GTX 200可以说有了成倍的性能增加,不仅在流处理数量方面的成倍增加,在跟图形处理器息息相关的几何着色器(Geometry Shader)及数据流输出(Stream Output)、ROPs、纹理填充率以及寄存器方面都有长足的进步。 目前,越来越多的游戏以及应用程序都需要大量的shaders,未来在shaders以及纹理单元上寻找一个最佳的平衡搭配,GeForce GTX 280显卡在每组TPC中,多添加了一次SM,然后保持TF的数量不变,这样一来shaders与TF的比值要比上代产品提高50%,非常适合目前以及未来的游戏和应用程序的需求。 3.2 提升几何着色器及数据流输出(Stream Output)的表现 从G80的架构图中,我们可以看到其统一渲染架构除了像素和顶点之外还包括了几何着色器(Geometry Shader),这是GPU中首次加入这样的运算单元。几何着色器也是SM4.0中新加入的内容,它第一次允许程序在图像处理器中创建新数据。这一革命性的事件使得GPU在系统中的角色由只可处理已有数据的处理器变成了可以以极快速度既可处理又可生成数据的处理器。在以前图形系统上无法实现的复杂算法现如今变成了现实。如此一来类似模板阴影(Stencil Shadow)、动态立方体贴图(Dynamic Cube Map)、虚拟位移贴图(Displacement Mapping)等依靠CPU或多通道渲染(Multi-Pass Rendering)的算法效率提升了很多。 几何着色器可以根据顶点的信息来批量处理几何图形,对顶点附近的数据进行函数处理,快速创造出新的多边形。通过steam out将这些结果传递给像素或者是缓冲区,将CPU从复杂庞大的几何运算中解放出来。大爆炸、粒子效果、瀑布流水、毛发渲染等复杂又关联的场景都可以用几何着色器很逼真的表现出来。 在DirectX 10之前,几何体必须在写入内存之前被光栅化并送入像素着色器(pixel shader)。DirectX 10引入了一个叫做数据流输出(Stream Output)的新特性,它允许数据从顶点着色器或几何着色器中直接被传入显存。这种输出可以被传回渲染流水线重新处理。当几何着色器与数据流输出结合使用时,GPU不仅可以处理新的图形算法,还可以提高一般运算和物理运算的效率。 随着DX10游戏的流行,在DX10规范中首次引用的几何着色器(Geometry Shader)作用用来越显著。为了提升GT200的游戏表现,GeForce GTX 280内部的输出缓冲限制已显著升至上代产品的6倍,提供了更快的几何着色器(Geometry Shader)速度以及数据流输出(Stream Output)表现。

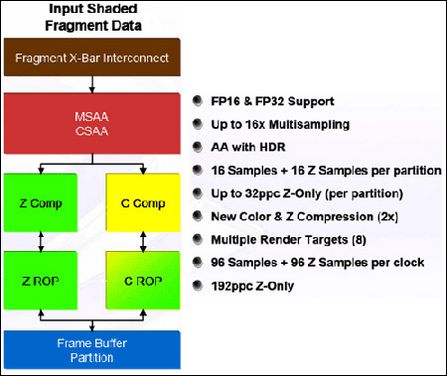

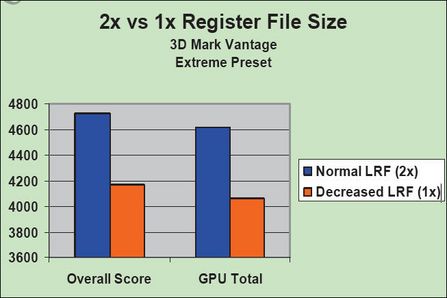

3.3 加倍的寄存器文件 在上代旗舰G80核心中,在每组流处理集(SM)里面添加了高速的本地缓存用于存放shaders之间计算完的活跃数据。但随着编程的复杂度增加,shaders的处理器能力也得到了成倍的增加,一次可完成上千条指令。寄存器的容量就成为了整个核心的瓶颈,当SM内寄存器的容量不足以保存全部处理后的活跃数据时,溢出的数据就会直接存放到显卡的显存当中,而本地显存较大的延时会严重影响性能。为了解决这个问题,适应未来更复杂的编程需求,在GT200核心的寄存器容量直接提升至上代产品的2倍,大大减少了数据溢出到本地显存的机率,使GT200的运算性能更强,运算效率更高。 3.4 升级ROPs(光栅化处理器) 前面我们说过G80的ROP支持超级采样和多点采样和Adaptive的这三种抗锯齿的模式, 因而G80是首个在单GPU环境下实现8x、 8xQ、16x和16xQ等抗锯齿模式的GPU。同时G80的ROPs支持(frame buffer)FP16和FP32的浮点像素混合,无论是FP16还是FP32都能够进行多采样抗锯齿,因而从G80开始,NVIDIA的GPU首次实现HDR+AA的模式。 最新的 GeForce GTX 200系列GPU ROPs不仅全部支持上代产品的特性,而且还实现了最大32 pixels输出每时钟,等同于八个ROP分区中每个ROP分区输出4 pixels每时钟,同时每个ROP分区在8X MSAA下支持32 色彩和Z采样每时钟。像素方面采用了U8(未签名8 bit整数)数据格式,像素的混合比率是上代产品的2倍。跟仅有6个ROP分区以及支持24 pixels输出每时钟,12 pixels混合每时钟的上代产品相比,GTX 280提升到支持32 pixels输出和混合每时钟。能给用户带来更绚丽更真实的视觉效果。

3.5 提高了纹理表现 在第一代统一架构G80核心中,GeForce 8800GTX显卡8个TPCs允许64 pixel的纹理过滤每时钟,32 pixel的寻址每时钟或者是32 pixels 2x各向异性过滤(8bit 整数),或者是每时钟32 pixels的双线过滤(8bit 整数或16bit浮点)。在后来推出的G92核心中,NVIDIA改进了纹理填充率的表现,GeForce 9800GTX显卡能允许64 pixel的纹理过滤和寻址每时钟,支持64 pixel的双线性过滤每时钟(8bit 整数),或每时钟32 pixels的双线过滤(16bit浮点)。 GeForce GTX 280再次提升了纹理的过滤与寻址能力。在每个TPCs(流处理集组)中提供了一个双四纹理(共8个)处理单元,能够提供每时钟8 pixels的双线数寻址和过滤,FB16双向材质过滤可以实现每时钟4 pixel来操作,如果是FP2:1的各向异性过滤也可以每时钟4 pixels来完成。内部集成的10个TPCs能同时完成每时钟80 pixels的双线数寻找和过滤。除此之外,GeForce GTX 280还创建了一个非常高效的程序来管理,使其纹理过滤表现能达到理论最大值,性能上较上代GeForce 9系列显卡有22%的提升。

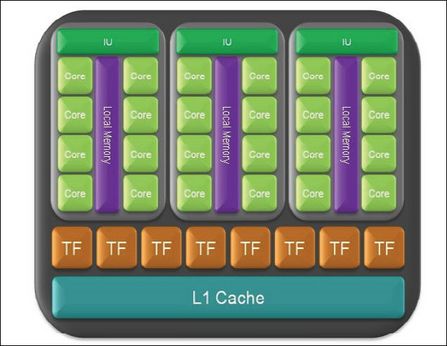

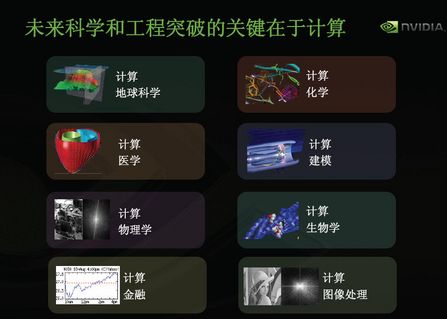

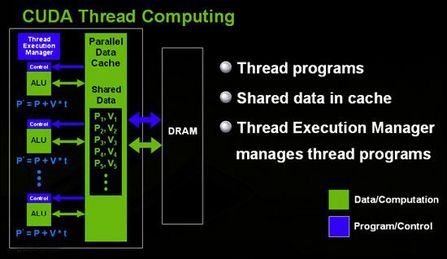

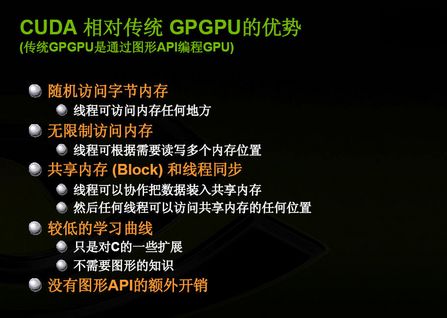

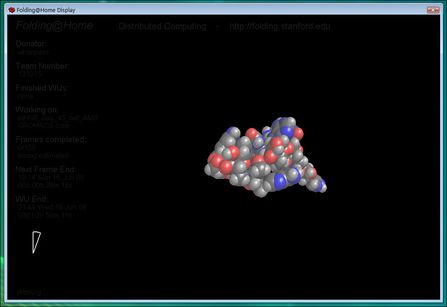

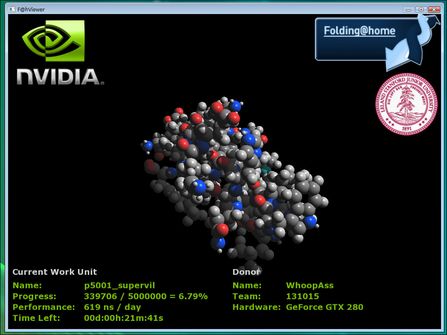

第4章 并行处理架构:GPU将比CPU更主要 除了在图形处理方面的升级,GeForce GTX 280同样是一款非常出色处理器并行架构处理器。跟上代产品相比,GT 200是一款更纯粹的为并行计算优化的核心,浮点运算能力也达到了933GFlops,是目前CPU处理器的10倍左右。而NVIDIA提出的CPU+GPU的异构运算平台在目前众多领域有着非常大的优势。随着越来越多的应用程序对GPU并行运算的支持,相信未来GPU重要性超过CPU也并非天方夜谭。 NVIDIA方面,上代G8X图形核心就采用了先进的统一渲染架构,拥有多达128个流处理器,引入几何着色器功能……这一切简直就是专为GPGPU运算而生!为了最大程度的发挥几何着色器的威力,G80还专门设置了一个名为流输出层(Stream Output State)的部件来配合它使用。这个层的功能是将Vertex Shader和Pixel Shader处理完成的数据输出给用户,由用户进行处理后再反馈给流水线继续处理。它可以直接读写本地显存。我们可以通过Stream Out把GPU拆成两段,只利用前面的一段几何运算单元。对某些科学研究,也可以通过stream out来利用GPU的数学运算能力,等于在CPU之外又平白多得了一个数学协处理器。我们可以这样理解G80图形核心的几何着色器和Stream Out单元:GS提供了改变图形数量的能力,Stream out提供了硬件Multi-pass的支持。可以预见,今后围绕这些全新的功能,又会有一批新的GPU通用计算程序出台。 GeForce GTX 280的推出,再次把并行运算带到了新的高度。从GeForce GTX 280的并行计算架构来看,与图形运算最大的区别在于,顶部省掉了专为图形处理的几何着色器(Geometry Shader)、Vertex Shader和Pixel Shader单元,取而代之的是一个基于硬件的线程管理器在顶部通过TPCs管理调度全部的线程。也就是说全部的线程都是由硬件管理调度的,而且在每个SM(流处理器组)里面都包含了一个本地高速16K的缓存,便于数据的交换。在架构的底部去掉了跟图形有关的ROPs(光栅化引擎),但仍然保留了tex L2缓存与显存接口,用于数据与显存间的交换。而且额外增加了一个Atomic单元,用于处理器数据间的冲突。 GeForce GTX 280的统一架构还提供了2种不同的处理器类型,例如,对于整个TPCs来说,它的构造是一个MIMD(多指令流多数据流)模型,这是一种全面的并行处理,典型的是多处理机。而对于内部的SMs来说,是一个SIMT(单指令多线程)结构。SIMT在纯SIMD(单指令多)设计的性能和编程应用性上都有所提高。除此之外,从程序员的角度来看, 由于采用硬件方面管理,SIMT还允许每个线程采用自己独立的路径和分支,所以没有必要手动管理分支内部的矢量宽度。 上代产品不支持双精度的问题也得到了解决,GeForce GTX 280支持双精度浮点运算,符合IEEE 754精度规范。 第5节 面向未来:CUDA应用方向 随着显卡的发展,GPU越来越强大,第一代统一渲染架构的GTX 280核心中就已经拥有240个单独的ALU,因此非常适合并行计算,而且浮点处理能力也远远优于目前的多核CPU,加上GPU为显示图像做了优化。在众多计算领域上已经超越了通用的CPU。如此强大的芯片如果只是作为显卡就太浪费了,因此NVidia推出CUDA,让显卡可以用于图像计算以外的目的。CUDA(Compute Unified Device Architecture)工具包是一种针对支持CUDA功能的GPU(图形处理器)的C语言开发环境,未来还将发布Fortran语言版本。 CUDA(Compute Unified Device Architecture)是一个新的基础架构,这个架构可以使用GPU来解决商业、工业以及科学方面的复杂计算问题。跟以往的GPGPU概念不同的是,CUDA是一个完整的解决方案,包含了API、C编译器等,能够利用显卡核心的片内L1 Cache共享数据,使数据不必经过内存-显存的反复传输,shader之间甚至可以互相通信。对数据的存储也不再约束于以往GPGPU的纹理方式,存取更加灵活,可以充分利用stream out特性。以上几点都将大大提高GPGPU应用的效率。例如,在游戏中我们可以使用CUDA来让GPU承担整个物理计算,而玩家将会获得另他们感到惊奇的性能和视觉效果。另外,用于产品开发和巨量数据分析的商业软件也可以通过它来使用一台工作站或者服务器完成以前需要大规模的计算系统才能完成的工作。这一技术突破使得客户可以任何地方进行实时分析与决策。同时,一些以前需要很先进的计算技术来达到的强大计算能力的科学应用程序,也不再受限在计算密度上;使用CUDA的计算可以在现有的空间里为平台提供更强大的计算性能。CUDA采用C语言作为编程语言提供大量的高性能计算指令开发能力,使开发者能够在GPU的强大计算能力的基础上建立起一种效率更高的密集数据计算解决方案。 CUDA工具包推出已有1年,它的推出马上受到了众多软件/游戏开发商以及科研机构和程序爱好者的欢迎,NVIDIA方面也将发布最新的CUDA 2.0版本。相信在未来,CUDA将会受到越来越多的领域的支持。目前,支持CUDA环境的GPU主要有采用统一渲染架构的显示核心。 BadaBoom视频压缩 一直以来,视频编码的转化都是令用户非常头疼的一件事,一款顶级的处理器在转换容量巨人的视频文件的时候,慢如蜗牛的速度令人难以忍受,这也主要受目前CPU性能的制约。目前,NVIDIA与许多软件开发商在推广支持GPU加速的视频压缩软件,Badaboom就是一款支持GPU加速的视频转换软件,可以把mpeg2的视频转换为ipod或者iphone这样的所使用的H.264视频格式,据称速度方面是目前CPU转化的10倍以上,为了验证其真实性,我们就做了一次相关的评测。 由于目前这个版本仅支持GPU加速,所以我们并不能拿来与CPU进行同平台对比,考虑到目前参差不齐的编码软件,测试结果仅做主观参考,从软件显示的编码速度来看,编码帧数达到了130帧每秒,一个160M的MPEG-2文件压缩至iphone标准视频仅1分钟内就可以编码完成。这个速度相信已经超过了目前所有的CPU版本编码软件。 Folding@home是斯坦福大学的一个分布式计算计划可以利用分布于全球的计算机模拟复杂的蛋白质折叠效应,是一款典型的科学计算程序,目前已经推出了支持CUDA环境的版本。该项目的客户端程序可以使用客户机的CPU或NVIDIA CUDA enable GPU或者AMD Radeon对同一以项目进行求解,为了让大家最清楚的了解CUDA的GeForce GTX 200系列GPU在科学计算方面与CPU和其他计算解决方案在性能上的区别。我们利用这款软件对GTX 280做了一次评测,测试所采用的处理器为Intel 45nm四核处理器QX9770,超频至3.6GHz(400x9)。

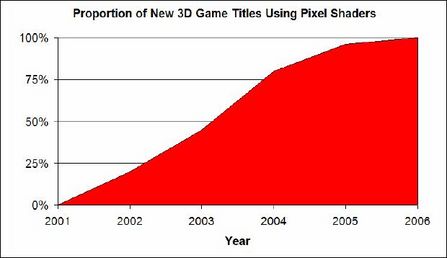

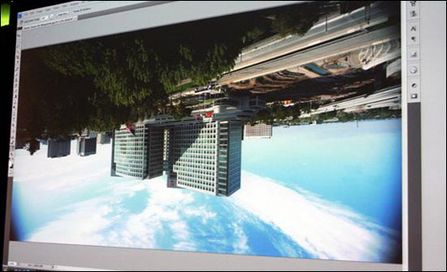

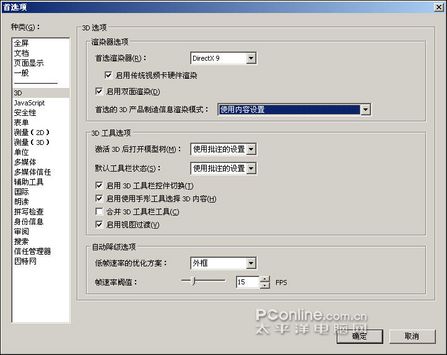

从测试的过程可以看出,支持CUDA的Folding@home的性能非常强大,能明显的感觉到远超过CPU版本,测试结果也达到了669.7ns/day。这个成绩基本上是目前CPU的100倍左右,GPU强大的并行处理能力在这体现无疑。 Photoshop CS4支持GPU加速 在加州圣克拉拉举行的2008年春季Editor's Day上,NVIDIA和Adobe带来了新的希望:代号“Stonehenge”(巨石阵)的Adobe Photoshop Creative Suite Next(也就是CS4)会加入对GPU、物理加速的支持。 如果您的计算机具有基于 AGP 或 PCI 的视频卡,则该计算机可能具有 GPU(图形处理器)。 如果您的 GPU 支持 DirectX 9.x、Pixel Shader (PS) 1.3 或更高版本,以及 Vertex Shader (VS) 1.1 或更高版本,则可以使用 GPU 加速效果,如“卷边”、“折射”和“波纹(圆形)”。 这些效果充分利用了 GPU 卡的增强视频处理功能,给图像增加了三维真实感。 有了GPU加速支持,用Photoshop打开一个2GB、4.42亿像素的图像文件将非常简单,就像在Intel Skulltrail八核心系统上打开一个500万像素文件一样迅速,而对图片进行缩放、旋转也不会存在任何延迟;另外还有一个3D加速Photoshop全景图演示,这项当今最耗时的工作再也不会让人头疼了。 IE小插件Piclens让2D变3D Cooliris推出的Piclens插件可以让google图片搜索以及youTube变为3D模式,通过用GPU硬件加速来实现图片浏览。但就是这么一个实用的小插件,没有GPU也是不行的。 当我们使用一块GeForce 9600GT进行GPU加速时,cooliris满速率运行可达60fps,但换用集成显卡时,这个数值还不到24fps,前后的差距至少达到了2.5倍,集显与独显的产品在日常应用中终于体现出来了。 连PDF都需要GPU加速 早在2007年,Adobe就与NVIDIA展开合作,推出了支持GPU加速的PDF版本,Adobe Acrobat 8及Adobe Reader 8系列产品提供全新的页面显示着色技术,利用GPU来加速PDF格式下的绘图及显示功能,除了在效能上有所增进外,还可以利用GPU的可编程特性,进一步加强PDF文件中的2D内容展示效果。 据Adobe平台产品营销总Pam Deziel表示,NVIDIA GeForce与Quadro GPU使用者可利用PDF档案进行更多样的作业,同时也能更有效率。包括平移、卷动、缩放等,实际上Adobe Reader 8每一项运用到GPU的功能都有着显著的效能增进。使用者过去避免使用的一些应用,例如可进行极精细比例缩放的地图,现在都可以轻易地显示。

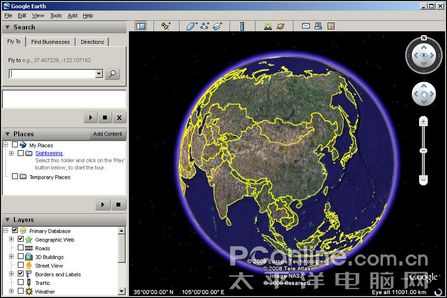

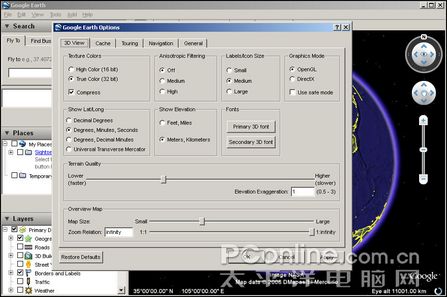

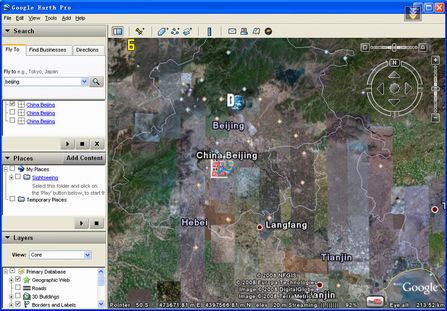

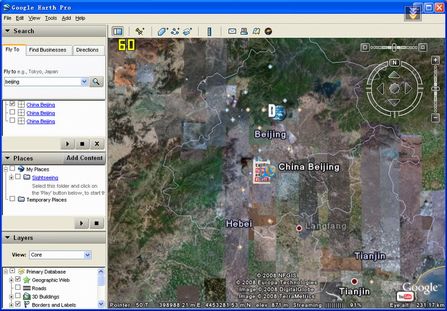

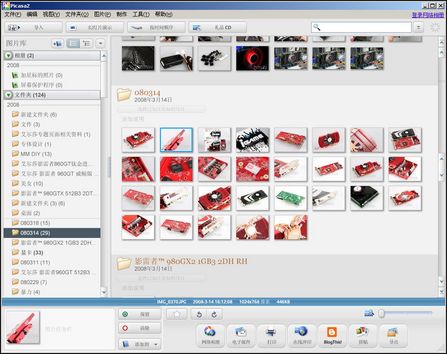

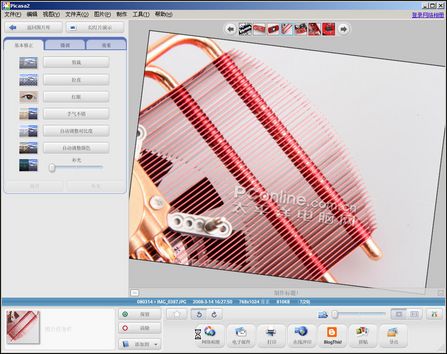

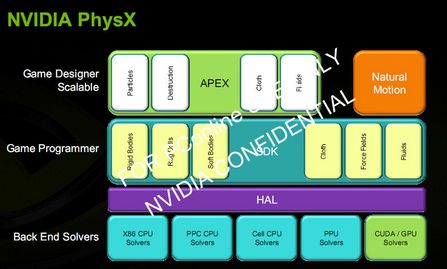

同样一个容量达到50MB的期刊读物电子版PDF文件,在使用传统方式打开时,读取时间为8秒。而使用GPU硬件加速功能时,打开时间不超过3秒,且在浏览时不会有拖沓感,PDF文件也变得流畅异常了。 Google Earth独显与集显也有区别 Google earth,是一款3D地图显示软件,它能够将地球上某一区域的地貌,以3D图像的形式展现出来。很显然,这类软件将会逐渐成为我们今后生活的必备软件。 在Google earth的设置界面,如果你拥有一个性能强劲的显卡,那么可以将画质设置为最高,这是在没有GPU加速功能的PC上无法体验的速度感。 当我们以最高画质量为限查找地图街景时,带有GPU的PC系统可以流畅地进行地图缩放。而同样的场景、同样的搜索速度、同样的处理器,在没有GPU加速时,运转速度简直无法忍受,在Fraps显示的速率上,使用GPU加速和不使用GPU加速情况下,速度落差达到了几十倍之巨,由此可见,GPU的作用和意义绝不仅限于游戏。 Google picasa显卡加速更强大 Google Picasa2是一款可帮助您在计算机上立即找到、修改和共享所有图片的软件,软件附带了常见的图片处理功能。 在使用NVIDIA显卡的电脑上使用Picasa软件,通过GPU加速,图片的拖放或文件夹切换,图片生成的速度都非常快,这跟我们采用NVIDIA的显卡是息息相关的。如果换用没有GPU加速的平台,搜索图片时生成速度是有明显差异的。 PICTOMIO速度更快 http://www.pictomio.com/Default.aspx Pictomio是一个类似于Picasa的图片浏览和管理软件,它提供了极其华丽3D图片浏览效果。如果PC中具备GPU,那么完全可以利用强大的GPU将浏览方式变更为3D模式,无缝缩放、渐变式切换,效果十分惊叹。但如果没有GPU,平面的交互效果实在是太过让人失望了。 如你所见,视频功能的日渐丰富是当今计算机发展的主流趋势,这些软件通过GPU 的提升可以明显的得到更快、更连贯的显示效果。而这些性能的改变单靠提升CPU的运算性能,是无法完全实现的。可以说,GPU强大的浮点运算能力转化为全新的应用方式,将成为PC机正在经历的一场全新变革;我们的数字生活也将会因GPU的改变而步入全新的视觉时代。 第6节 GTX280:最先进的物理特效 随着NVIDIA收购AGEIA公司,业界最先进的PhysX物理加速技术的加入,让大家对于GPU支持物理加速期待已久。随着GeForce GTX 280显卡的面世,最新的PhysX物理加速技术终于浮出了水面,按照NVIDIA自己宣称的PhysX是目前最先进的物理加速引擎。 PhysX是目前支持平台最多的物理加速引擎,他可以支持目前主流的X86处理器、AGEIA公司的PPU、东芝公司的Cell以及支持CUDA环境的GPU。其中,最令人期待的就是支持CUDA的版本。借助于目前强大的GPU并行运算能力,支持CUDA环境的PhysX物理加速引擎能给用户带来最为真实的性能体验。 随着物理引擎的加入,以后我们就可以在游戏中体验最为真实自然的服装、毛发、烟雾、爆炸等画面,可以进一步的解放目前不堪重负的CPU。

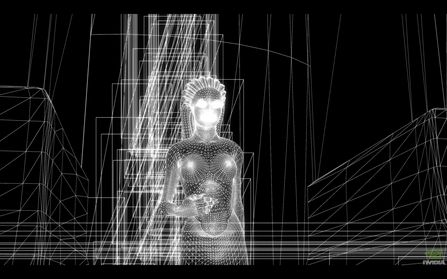

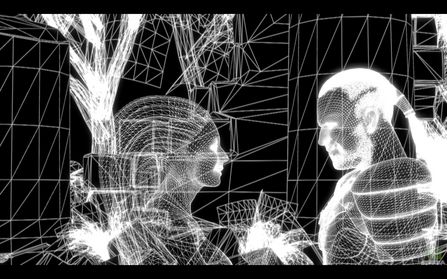

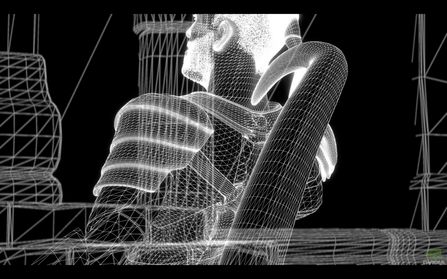

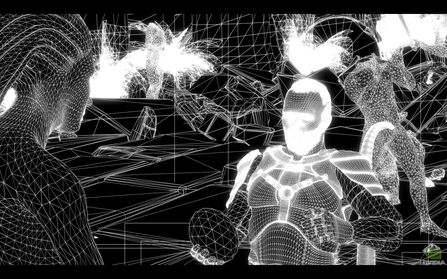

第7节 新的代言人:美杜莎DEMO欣赏 戈耳工美杜莎是希腊神话中的蛇发女妖三姐妹,居住在遥远的西方,是海神福耳库斯的女儿。她们的头上和脖子上布满鳞甲,头发是一条条蠕动的毒蛇,长着野猪的獠牙,还有一双铁手和金翅膀,任何看到她们的人都会立即变成石头。宙斯之子珀尔修斯知道这个秘密,因此背过脸去,用光亮的盾牌作镜子,找出美杜莎,在雅典娜和赫耳墨斯的帮助下割下了她的头。从美杜莎的躯体里跳出双翼飞马珀伽索斯和巨人克律萨俄耳,他们都是波塞冬的后代。珀尔修斯躲避美杜莎两个姐姐的追杀时,在空中遇到狂风的袭击,被吹得左右摇晃,从美杜莎的头颅上滴下的鲜血落到利比亚沙漠中,成为毒蛇。 在蛇发女妖三姐妹中,只有美杜莎是凡身,她的姐姐丝西娜和尤瑞艾莉都是魔身。据说美杜莎曾经是一位美丽的少女,因吹嘘自己比雅典娜长得漂亮而被这位智慧女神夺去了她的所有美丽,只留给她一个丑陋的妖怪之躯。 本作是由NVIDIA自主开发的一款全3D实时渲染3D DEMO,在DEMO中,NVIDIA将目前GTX 280显卡所支持的特效发挥的淋漓尽致,画面效果、人物模型、包括人物皮肤、衣服、烟雾、光影都做的非常逼真。在DEMO中我们还可以实时观测到画面所采用的3D多边形。 29回顶部 30回顶部 第8节 最强DX10显卡GTX280揭秘 GeFore GTX 280显卡在体积上仍然保持着上代旗舰产品的体型,外观设计也基本上保持一致,硕大的散热器把PCB板包裹的严严实实,更加深了其神秘感。GeFore GTX 280显卡作为目前的顶级显卡,基于全新的GT200-D10U核心,仍然采用了65nm工艺制程,拥有240个运行在1296MHz的流处理器,显存位宽也提升至其所未有的512bit,Rops与纹理单元也提升至64/80个,默认核心/显存频率为602/2200MHz。 NVIDIA的高端显卡都流行凹槽设计,GeFore GTX 280采用了酷劲十足的切面设计。 继上代旗舰GeForce 9800 GX2之后,nVida再次把背面PCB也全部包裹起来。 32回顶部 第9节 GTX280内部结构惊人 作为一款顶级显卡,GeForce GTX 280在供电的做工跟用料上自然不用多说,不计成本的大量采用了陶瓷贴片电容以及封闭式电感。采用VOLTERRA的数字供电方案,主控芯片为VT1165MF搭配5颗VT1165SF芯片为GTX200核心提供5相供电,显存方面也采用了2两相供电。 GeForce GTX 280显卡再次给我们带来了全新的NVIO芯片,第一次采用NVIO分离设计的G80核心获得了众多FANS的欢迎,全新升级的NVIO二代芯片在接口方面更丰富,支持DisplayPort接口,并且带来真正双Dual-Link XHD DVI 10bit每通道的色彩输出能力。 显存方面搭配的是16颗现代GDDR3显存颗粒,组成512bit/1GB显存规格。显存编号为H5RS5223CFR,这也是目前现代推出的最强PC用显存,运行频率为2200MHz。 由于晶体管数量有了成倍的增加,GT200核心面积也达到了前所未有的高度,达到了564mm2,而封装面积接近于4枚1元的硬币大小。 第10节 正式版GTX280显卡鉴赏 首款正式版GTX280:讯景GTX280欣赏 讯景是首批推出GeForce GTX 280显卡的厂商之一,从图片可以看出,这款显卡的完成度是非常高的,显卡大面积的贴上了彩贴,使这款旗舰显卡更添阳刚之气。频率方面也保持了公版的规格,为602/2200/1296MHz。 映众GeForce GTX 280鉴赏 作为AIC厂商的映众,也在第一时间推出了旗下的GeForce GTX 280显卡,这款显卡除了在散热器上面打上了LOGO外,其他地方无公版无疑。频率方面也是公版的602/2200/1296MHz。 影驰超频版GTX280鉴赏 影驰这款显卡最大的特点就是采用了超频规格,这也是目前已知的首款超频版GeForce GTX280显卡,频率方面为620/2200/1400MHz。在外观上,这款显卡采用了颇具内涵的图腾图案。 丽台GTX280显卡鉴赏 丽台的GeForce GTX280显卡同样是一款公版规范的显卡。不过,此次丽台是同时推出了自己的GTX280以及GTX260显卡,相信马上就有GTX260上市的消息。 盈通GTX280显卡鉴赏 盈通是目前我们收到的唯一一款通路品牌,这款显卡仍然采用公版设计,相信上市后,在价格上会比其他品牌更具优势,喜欢的用户可以关注下。 第11节 评测平台及评测方法简介

在测试平台上面,我们采用了顶级的四核平台,为了避免处理器带来的瓶颈,我们把处理器超频至3.6GHz。分辨率我们选择了目前顶级的画质设定,以来考察这个等级的显卡性能水平,二来针对第二代统一架构带来的优化进行实战。所有测试中,帧数在10帧以下的成绩我们都记为0分。 第12节 GTX280显卡3D性能对比评测 3DMarkVantage测试成绩对比 新的3DMark测试工具——3DMark Vantage并没有提供对显卡DirectX 9性能的测试部分,因为FutureMark认为,作为DirectX 9.0C的测试工具,3DMark 2006就已经很好的反映显卡的DirectX 9性能,因此3DMark Vantage是一款完全针对DirectX 10开发的测试软件,用户也需要安装支持DirectX 10的Windows Vista才能运行,看来Windows XP和DirectX 9显卡用户是和这款3D测试工具无缘了。 3DMark Vantage主要包括了Graphics Test和CPU Test两个测试部分,它们各自带有两个测试场景,其中Graphic Test包括Jane Nash、New Calico,主要针对显卡的3D图形渲染性能。而CPU Test就包括AI和Physics两个部分,分别测试处理器的AI运算和物理加速性能,在现在的游戏发展中,除了图形3D性能以外AI和物理运算都是游戏中极其重要的部分,在新的3DMark中对这四项目都进行了测试,无疑更能反映整个平台的游戏性能。 3DMark Vantage 总得分标准: 3DMark=1/(显卡权重系数 / 显卡总分+CPU权重系数 / CPU总分) 3DMark Vantage认为不同级别的测试模式,显卡和CPU之间的权重比例是不一样的,因此四个测评模式下的评分标准也不一致,下面我们来看看四个模式中,显卡和CPU的权重比为多少:

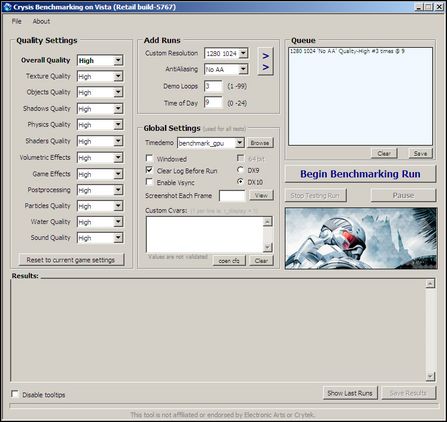

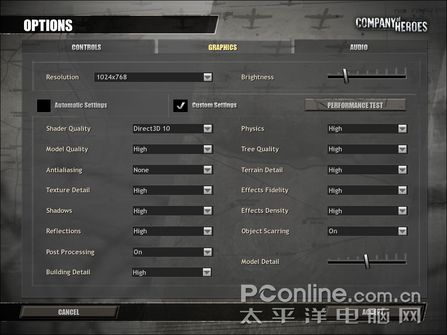

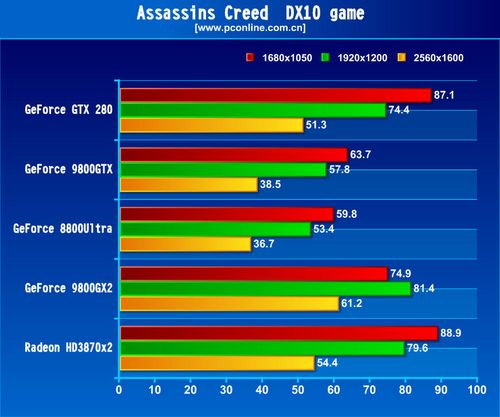

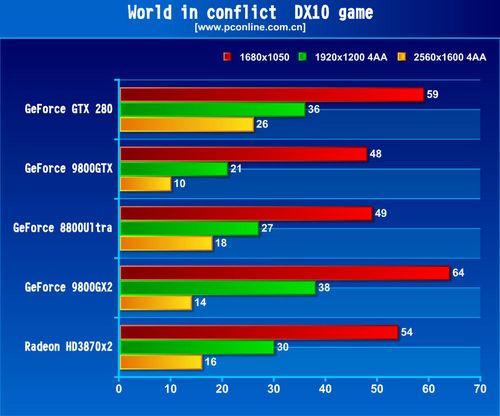

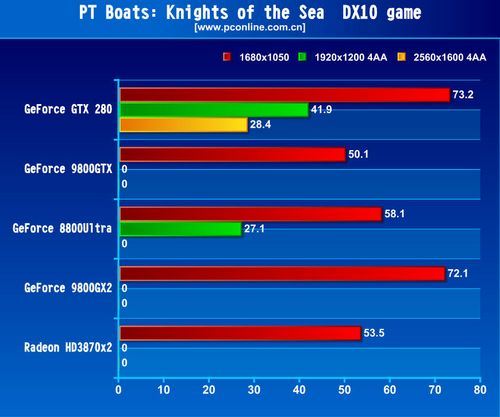

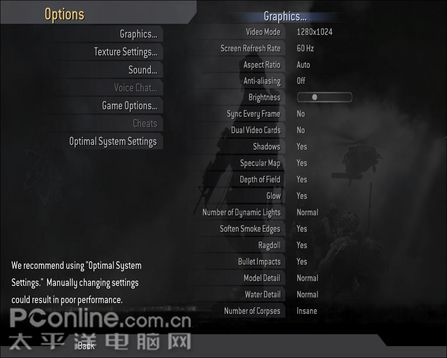

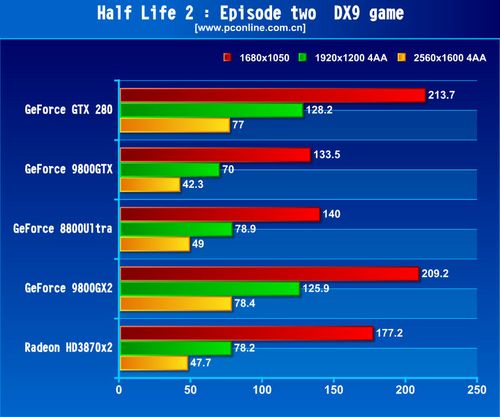

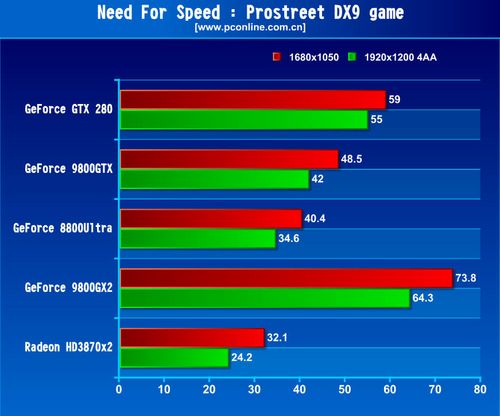

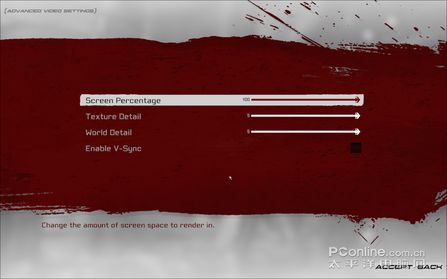

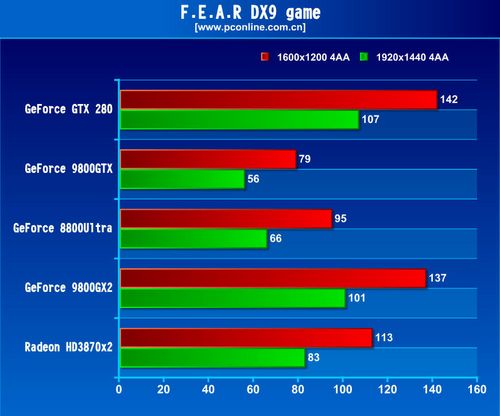

测试结果: 对比评测-3DMark06性能评测 3DMark06 分项计算公式: HDR/SM3.0 得分 = 100 x 0.5 x (SM3 GT1 fps + SM3 GT2 fps) * Sqrt即平方根 测试相关公式: SM3.0 硬件设备GS得分 = 0.5 x (SM2S + HDRSM3S) 3DMark06 总分的计算公式: 3DMark06 总分 = 2.5 x 1.0/(( 1.7/GS + 0.3/CPU得分)/2) (太平洋电脑网3Dmark06本地下载地址) 3DMark06的标准评测包括两个HDR评测两个SM3.0图形评测。3Dmark06还首次使用了AGEIA公司的PhysX物理引擎,用CPU模拟物理引擎计算,这是3Dmark06的一个闪亮的特色。CPU评测的成绩被强制加入到总分里面去,Futuremark揭示了未来游戏发展的方向,CPU/GPU应该获得更好的平衡。而评测中,我们选择了标准分辨率1920x1200,开启AA/AF特效。 《孤岛危机》Crysis性能对比评测 测试画质说明 如果说著名的FarCry《孤岛惊魂》敞开了第一代DX9游戏的大门,那么同样是由CryTek公司制作的FarCry续集——Crysis《孤岛危机》,将很有可能为大家敞开DX10游戏的另一道大门。 由于Crysis是目前对显卡要求最高的DX10游戏,因此在本次评测中,我们将分辨率锁定在1680x1050、1920x1200、2560x1600所有的画面设置都调至高,同时关闭/开启AA和AF两组测试。为了避免测试误差,我们使用了目前最新的Benchmark测试,画质全部设置为HIGH。 英雄连《Company Of Heroes》性能对比评测 测试画质设定 上图是关于英雄连《Company Of Heroes》的测试画质设定:Shadow Quality设置为DirecetX 10模式、全部特效都开启至最高。 DX10游戏对比评测:《ASSASSINS CREED》 故事背景设定为12世纪末的欧洲,玩家扮演身手不凡的刺客Altair,为了结束帮派斗争而进行一项项暗杀任务。游戏已第三人称视角表现,游戏风格不乏《波斯王子》的熟悉感觉,不过本作将会以极为华丽的游戏画面重新包装起来,对于喜欢第三人称动作游戏的玩家本作绝对吸引。 测试画质设定如上:我们将所有画质调至最高,画面质量、阴影、图形细节等设置为参数"3",分辨率选择为1680x1050、1920x1200、2560x1600。 我们选择了画面一开头的场景为测试地点,利用Fraps记下平均帧数,反复测试3次取最大值为评测成绩。 DX10游戏性能评测:《World in conflict》冲突世界 游戏说明 本作是一款以虚拟全球冷战为故事背景的RTS游戏,游戏支持DX9与DX10特效间的转换。在这款游戏中,我们把画面选项设定为非常高(DX10),以自带BenchMark工具测试。 DX10游戏性能评测:《PT Boats》鱼雷快艇:海洋骑士 游戏说明: 表现海战的游戏在游戏行业中并不多见,这主要是因为水的透明效果和对光的折射、反射、散射等现象较难进行3D处理,而依靠DirectX 10的支持,在3D游戏中处理水的效果也终于能够实现。 海战是所有军事迷最感兴趣的部分,对于军事类游戏自然也不例外,《鱼雷快艇》这款游戏描绘的是二战时期的海战故事,玩家操控鱼雷快艇可以体会到高速度、机动性强的攻击感受。当然,在游戏中,玩家千万不要忘了对自己的保护,鱼雷快艇没有很好的防御功能,只能采用快打快跑的战术。 由于本作是首款支持DX10特效的海战类游戏,在画面的要求上是比较高的。在游戏设置中,我们选择了1680x1050 NOAA 、1920x1200 4AA、2560x1600 4AA。 《使命召唤4》Call OF Duty 4对比测试 画质说明 关于Call OF Duty4的画面设置如上,所有特效开至游戏能够支持的最高级别,同时关闭垂直同步。 我们选择了大雨滂沱的快乐歌运输号,在直升机至船上的那段场景,用Fraps记下平均帧数,每个分辨率跑两次以两次测试平均值的最大值为成绩。 《半条命2:第二章》详细对比评测 画质设置介绍 《半条命2:第二章》引擎在HDR和游戏解说系统上继续增强。《半条命2:第二章》引擎当中的游戏子引擎将支持豪华的室外场景,树叶渲染上将采用Alpha覆盖技术,提供更好的树叶细节和反锯齿效果。《半条命2:第二章》引擎引入全新的粒子系统,将提供动态软阴影效果。《半条命2:第二章》引擎当中的物理子引擎也经过重新设计,提供大场景大范围的物理效果。下面是关于《半条命2:第二章》的画质设定及评测说明。 我们将游戏的特效全部开至最高,分辨率为1680x1050、1920x1200 4AA、2560x1600 4AA。 《半条命2:第二章》的评测我们选择了崖边的场景,测试过程中,我们跑到崖边等待游戏画面的闪光至震荡完毕,用Fraps记下3次的成绩取其平均值的最大值为测试成绩。 《极品飞车11》性能详细对比评测 画质设置介绍 评测画质如上面设置,所有特效开至最高,分辨率锁定1680x1050、1920x1200 4AA。 《Unreal Tournament 3》虚幻竞技场3 详细对比评测 画质设置介绍 关于虚幻竞技场3游戏的详细画质设定如下,如下图。 纹理贴图细节“Texture Detail”、环境的细节“World Detail”全开,关闭垂直同步“Enable V-Sync”等等。由于UT3目前在游戏中VISTA系统下ATI仍不能很好的打开抗锯齿特效,所以我们并没有在控制面板中强制打开抗锯齿特效,测试分辨率为1680x1050、1920x1200、2560x1600。 F.E.A.R性能测试画质设定 我们将所有的画质特效开至最高,分辨率锁定1600x200和1920x1440。开启AA/AF特效,我们采用了游戏自带的测试工具来进行评测。

第13节 GTX280功耗方面的改进 在功耗方面,GeForce GTX 280同样也做了非常大的改进,相对于峰值236W的功耗水平,GeForce GTX 280会随着显卡运行的环境而进行不同程度的降幅。这个技术类似于ATI目前的Powerplay技术,BIOS里面设置了4个不同等级的运行频率。通过调节显卡运行的频率来达到降低功耗的目前。目前,GeForce GTX 280支持四种不同的运行频率。分别是:空载或2D模式下,最低功耗为25W;高清视频模式下为35W;3D运行模式下236W;还有就是HybridPower模式下可以关闭显卡的运行。 可以看到,目前NVIDIA的高端系列显卡都将支持其独门的HybridPower技术,HybridPower混合动力是NVIDIA最新发布的混合SLI技术中的一项新技术。主板芯片组能根据目前的运行环境,通过SMBUS总线,向显示芯片组发送动作指令,来控制集成/独立显卡的运转。这是一项专为高端用户解决噪音及功耗问题的新技术。当然,此项技术也要有专门的主板芯片组支持。目前,已知的芯片组有NVIDIA面向AMD平台的nForce 780a SLI/nForce 750a SLI主板芯片组。在需要时,混合动力(HybridPower)技术能够将图形性能全部释放出来,也可以在做日常计算处理的时候关闭独立显卡,切换到低噪音低功耗的工作状态。而在做日常计算处理任务的时候,比如浏览网页、编辑文档或者观看高清视频,它将智能转换到低功耗、低噪音状态。 显卡功耗对比评测 从上面可以看出,虽然GeForce GTX 280在性能上“堪称无敌”,但其在功耗的控制上也是可圈可点的,为了进一步考察GTX280的表现,我们做了一次简单的整机平台对比评测,评测平台仍然采用的是3D测试平台,测试数据为整机功耗。在测试当中,我们加入了一款双芯单卡的HD3870x2的测试属数据作为参考,测试环境分为:主板BIOS待机、主机空载、高清回放以及3DMark 06测试。 从测试结果来看,GeForce GTX 280显卡,在功耗表现方面基本上与AMD-ATI HD3870x2显卡保持在一个水平,新加入的功耗控制技术也发挥了积极的作用。这突出表现在主板BIOS以及系统空载的情况下面。尤其在系统空载的情况下,GeForce GTX 280显卡的功耗表现甚至比目前主流的8800GT显卡还要低。 PConline评测室总结: Unified Shader架构的进一步优化以及参数的提高、拥有240个流处理器的Geforce GTX 280性能并没有令我们失望。1680x1050主流分辨率也基本上成为GTX280这个等级的显卡入门分辨率,而专门为目前及未来的DX10游戏优化的GTX280显卡,即使在目前极其苛刻的画质下(2560x1600 4AA)也保持着较高的帧数,与第一代统一架构产品相比,Geforce GTX 280的优势随着分辨率和AA/AF选项的打开而扩大,这也证明了我们选择这个等级的分辨率测试的正确性。在测试的6个DX10游戏中,Geforce GTX 280在1920x1200 4AA/2560x1600 4AA画质下,性能甚至有了成倍的提升,这突出表现在DX10 3D基准测试软件3D Mark Vantage中,得分是目前9800GTX显卡的2倍多。 不过不可否认,NVIDIA的上代旗舰,拥有双G92核心的GeForce 9800 GX2显卡在部分游戏中仍然拥有一定的优势,但这个优势基本上也仅保持在较低的分辨率下或低画质下,而随着未来DX10游戏的流行,游戏的画面将会越来越复杂,对显卡shaders的需求也会越来越高,较低的流处理数量以及显存位宽自然会捉襟见肘。而全新优化了FB/TEX比值以及改进几何着色器及数据流输出(Stream Output)表现的GeForce GTX 280拥有更好的前景。可以说,GeForce GTX 280是一款真正意义上“高瞻远瞩”的显卡产品,他进一步的成熟运用了DX10带来的Unified Shader架构。 市场方面,GeForce GTX 280会替代GeForce 9800 GX2显卡占领高端市场。面向次级市场,NVIDIA还会推出一款全新的产品,同样是基于GT200核心,但无论流处理数量、时钟频率、ROP数目、显存带宽和显存容量都跟旗舰的GTX 280拉开了足够的距离。Geforce GTX 260 显卡集成 14亿个晶体管,其核心频率576MHz。虽然集成数量众多的晶体管,但其中相当部分是被关闭的 。显卡总共拥有192颗流处理器单元,其流处理器频率1242MHz。显卡配备了896MB GDDR3 显存,其显存频率达到了1998MHz ,可以提供111.9GB/s 的数据传输带宽,最大功耗为182W,3D性能方面超过目前的9800GTX显卡没有多大问题,如此一来,9800GTX沦为中端也已成定局。

除了3D性能,GeForce GTX 280令人期待的地方还有很多,例如支持CUDA的PhisX物理加速引擎,能让我们体验更加真实的游戏特效的同时也进一步的解放我们的CPU。CUDA方面,随着GPU的发展,GPU越来越强大运算的速度也越来越受到软件开发商、游戏开发商以及科研人员的关注,相信将会有大批的软件涌入市场,而GPU强大的并行处理器能力也会令我们的工作效率有成倍的提高,而显卡仅局限于3D游戏的局面也将会成为历史。 |

|||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

正在阅读:问鼎显卡性能之王!NV旗舰GTX280全球同步首发问鼎显卡性能之王!NV旗舰GTX280全球同步首发

2008-06-16 22:53

出处:PConline原创

责任编辑:luoqi